Neue Shopify-Funktion: So erstellst du eine individuelle robots.txt

Seit dieser Woche haben alle Shopify-Nutzer die Möglichkeit ihre robots.txt individuell zu bearbeiten. In diesem Artikel erfährst du, wofür die robots.txt da ist und wann es sinnvoll ist von der neuen Funktion Gebrauch zu machen. Außerdem erklären wir dir Schritt für Schritt, wie du vorgehen musst, um die Datei individuell anzupassen.

Shopify arbeitet ständig daran das Shopsystem zu verbessern. Dazu gehören auch Maßnahmen, die in den Bereich der Suchmaschinenoptimierung fallen. Vor einigen Tagen wurde ein neues Feature ausgerollt, das die individuelle Bearbeitung der robots.txt ermöglicht. Seit dieser Woche steht diese Funktion sämtlichen Shopify-Nutzern zur Verfügung.

Was ist die robots.txt?

Bei der robots.txt handelt es sich nüchtern betrachtet um nichts anderes als eine schlichte Textdatei, die in dem Stammverzeichnis der Website abgelegt wird. Ihre Funktion jedoch hat es in sich. Denn mit der robots.txt lässt sich steuern, wie sich Suchmaschinen auf deiner Website oder in deinem Onlineshop verhalten.

Um das genau zu verstehen ist es wichtig zu wissen, wie Suchmaschinen arbeiten, um die einzelnen Seiten deines Shops in den Suchergebnissen anzuzeigen. Suchmaschinen wie Google schicken Suchroboter durch das World Wide Web, die es systematisch durchsuchen und analysieren. Sie werden Webcrawler genannt und sind nichts anderes als Bots. Manche bezeichnen sie auch als Spider, weil sie sich – vereinfacht ausgedrückt – von Link zu Link hangeln und so ein Netz spinnen.

Jede Suchmaschine und viele andere Onlinedienste haben ihren eigenen Crawler – oft sogar mehrere. Durch das Crawlen finden Suchmaschinen neue und aktualisierte Seiten und können diese in den Suchindex aufnehmen. Allerdings ist das Crawlen weder Voraussetzung noch Garantie für eine Indexierung. Seiten können auch ohne Besuch des Crawlers im Index landen und trotz Besuch des Crawlers nicht indexiert werden, weil das Ergebnis der Analyse zum Beispiel mangelnde Relevanz ergibt.

Bevor ein Crawler die Seiten deines Shops durchsucht, wirft er quasi einen Blick in die robots.txt und schaut, ob dort irgendwelche Hinweise oder Einschränkungen stehen. Man könnte die Datei auch mit der Hausordnung vergleichen, die einzelnen Anweisungen mit einem STOP-Schild. Denn hier kannst du mittels bestimmter Anweisungen verschiedene

- Dateien,

- Unterseiten,

- Verzeichnisse und

- komplette Crawler

ausschließen. Steht nichts in der robots.txt, dann heißt das im Umkehrschluss, dass alle Crawler alle Bestandteile deines Shops crawlen dürfen. Außerdem lassen sich Verzögerungsregeln für Crawler definieren und Sitemaps einrichten. Die robots.txt ist also ein wichtiges Werkzeug, um die Aktivitäten von Suchmaschinen zu steuern.

Gut zu wissen!

Die robots.txt ist kein offizieller Standard, sondern eher ein Gentlemen‘s Agreement. Das heißt, dass Suchmaschinen nicht dazu verpflichtet sind, sich an die Anweisungen in der Datei zu halten. Alle seriösen wie Google und Bing tun das jedoch. Bots von Hackern wird man damit aber leider nicht aussperren können, denn diese ignorieren die robots.txt einfach. Es ist wie im Straßenverkehr: Der Großteil der Verkehrsteilnehmer hält am STOP-Schild und ist sich seines Nutzens bewusst. Die Rowdies jedoch ignorieren das Schild wissentlich.

Wann macht eine Anpassung der robots.txt Sinn?

Jeder Shopify-Shop verfügt prinzipiell über eine robots.txt, die die Programmierer des Shopsystems mit den Angaben gefüllt haben, die sie für sinnvoll erachten. So wird zum Beispiel das Backend für die Suchmaschinen gesperrt, weil das natürlich nichts in den Suchergebnissen verloren hat. Du kannst deine Standard-Robots unter www.url.tld/robots.txt aufrufen und einsehen. Der Inhalt dieser Datei kann nicht geändert werden. Du kannst sie nun aber durch deine individuelle robots.txt ersetzen.

In der Praxis wird die Datei oft dafür verwendet, um zu verhindern, dass bestimmte Seiten in den Suchindex gelangen. Dafür ist die robots.txt allerdings nicht gemacht. Denn prinzipiell können Seiten auch ohne den Aufruf eines Crawlers indexiert werden, wenn zum Beispiel eine andere Seite auf deinen Shop verlinkt. Google rät deshalb ab die robots.txt dafür zu nutzen, Seiten vor der Google Suche zu verbergen. Stattdessen solltest du das über den Meta-Robots-Tag im Head-Bereich der jeweiligen Seite regeln, indem das Attribut „nofollow“ verwendet wird:

<meta name="robots" content="noindex" />Leider gibt es bei Shopify keine Möglichkeit diese Meta-Anweisung individuell für einzelne Seiten zu setzen. Du kannst sie nur für das gesamte Theme tätigen. Eine Lösung bietet ShopifyFD, eine kostenlose Erweiterung für den Chrome Browser von Google. Das Tool blendet in der Sidebar des Backends eine Box ein, mit der individuelle Meta-Angaben erzeugt werden können. Für Mediendateien wie Bilder, Videos und Audios ist die robots.txt übrigens der richtige Weg, um diese vor Google zu verbergen. Bedenke aber immer, dass du damit nur den Aufruf durch die Suchmaschine nicht jedoch durch einen Besucher verhindern kannst.

Zurück zur robots.txt: Ihre eigentliche Funktion ist es den Crawling-Traffic zu verwalten. Das ergibt dann Sinn, wenn der Crawler deinen Server mit seinen Anfragen überlastet. Auch das Crawling-Budget lässt sich mit der Textdatei schonen. Zwar ist der Google Bot bemüht bei jedem Besuch deines Shops so viele Seiten wie möglich zu crawlen, aber letztlich sind seine Ressourcen begrenzt. Deshalb hat jede Seite ein individuelles Crawling-Budget, das von verschiedenen Faktoren, wie zum Beispiel der Aktualisierungshäufigkeit, abhängt. Ist das Budget erschöpft, sucht der Crawler die nächste Website auf. Dadurch entgehen ihm möglicherweise neue oder überarbeitete Seiten, die erst mit Verzögerung erfasst werden. Werden unwichtige Seitenbereiche vom Crawling ausgeschlossen, bleibt mehr Budget für die relevanten übrig.

Typische Seiten, die nicht ständig vom Crawler besucht werden müssen und ohnehin lieber nicht im Index erscheinen, sind zum Beispiel Kontaktseiten mit einem Kontaktformular (verringert die Spamquote) oder die Datenschutzerklärung (senkt das Abmahnrisiko, weil veraltete Passagen nicht so einfach gefunden werden können). Auch die Seiten, auf denen der Kaufvorgang stattfindet, sind für Suchmaschinen irrelevant.

Wichtig!

Shopify hat zwar die Möglichkeit geschaffen eine individuelle robots.txt anzulegen, leistet dafür allerdings keinen Support. Du solltest dir bewusst sein, dass fehlerhafte Anweisungen verheerende Folgen haben können. Schon ein Zeichen an der falschen Stelle kann zur Folge haben, dass dein Shop nicht mehr in den Suchergebnissen auftaucht und der Umsatz einbricht. Ändere die robtots.txt deshalb nur dann, wenn du dich wirklich damit auskennst und beauftrage ansonsten einen Shopify-Experten. Wir stehen dir gern mit Rat und Tat zu Seite!

Wie kann man die robots.txt bei Shopify ändern?

Um eine individuelle robots.txt zu nutzen, musst du die Vorlage robots.txt.liquid hinzufügen. Liquid ist eine Open-Source-Template-Sprache, die von Shopify entwickelt wurde. Liquid ermöglicht es Shopify die Datei auch in Zukunft automatisch zu aktualisieren.

Folge dieser Anweisung, um die robots.txt.liquid hinzuzufügen:

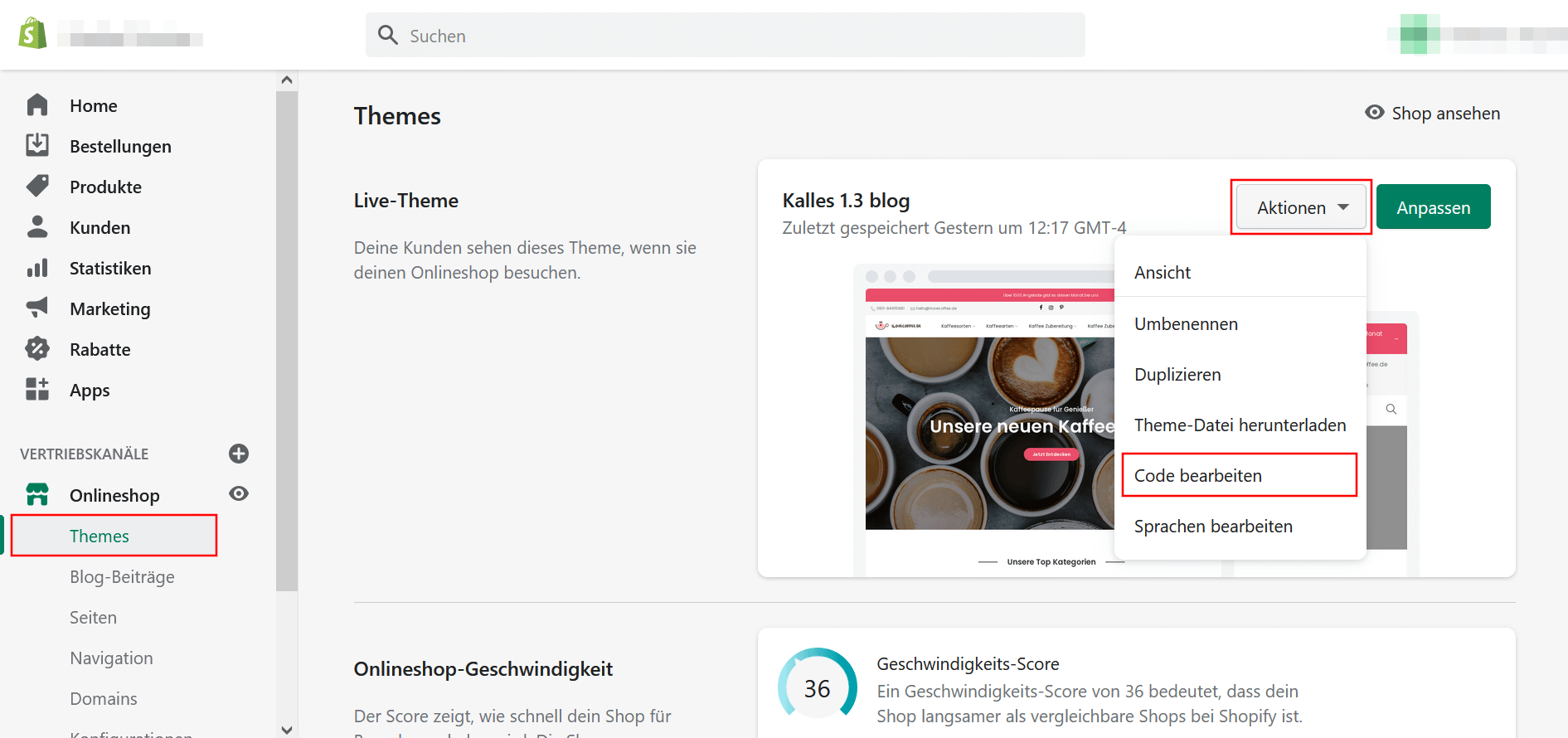

- Wähle im Adminbereich links im Menü den Punkt „Onlineshop“ -> „Themes“.

- Klicke auf den Button „Aktionen“ und wähle den Punkt „Code bearbeiten“ aus.

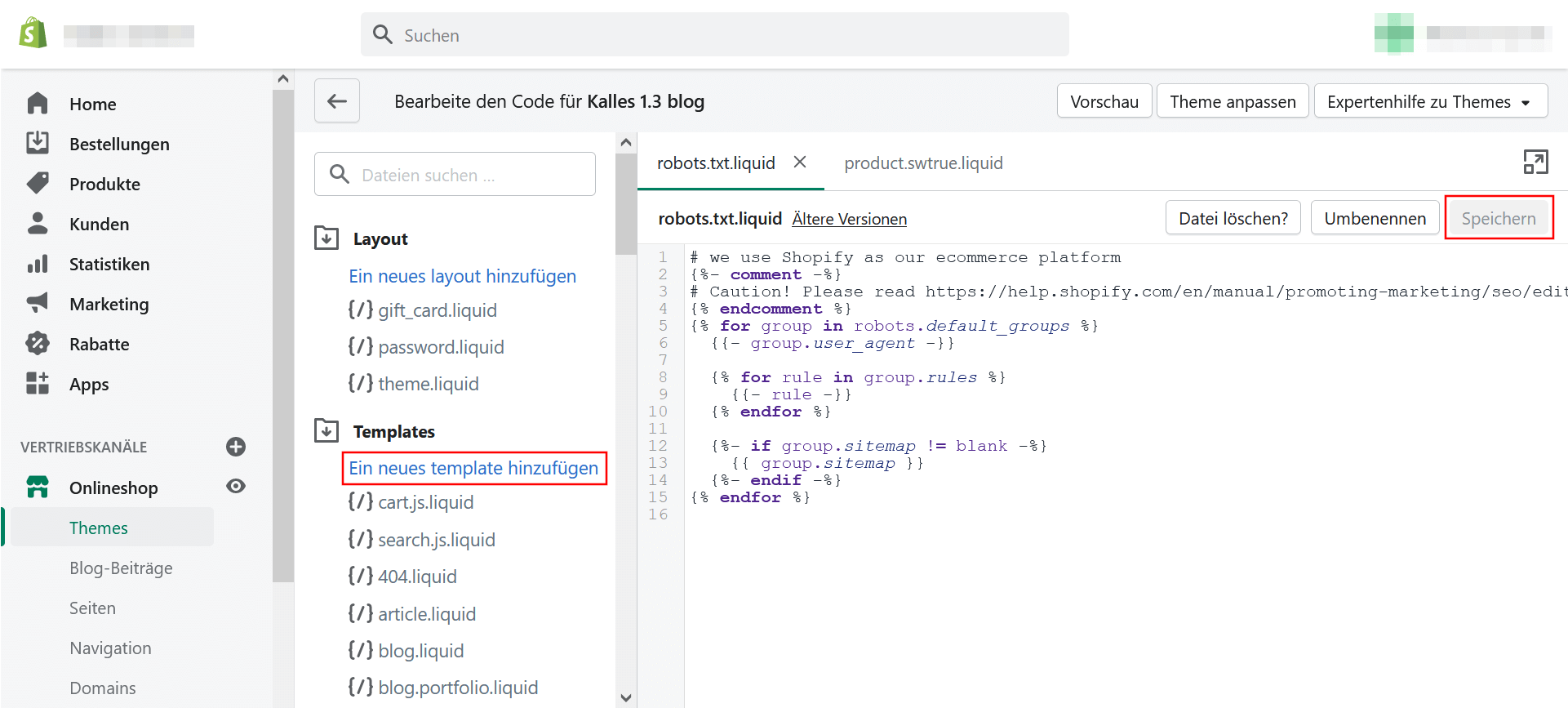

- Klicke unter Templates auf den Link „Ein neues template hinzufügen“.

- Wähle im Drop-Down-Menü die Vorlage robots.txt aus und klicke auf den Button „Vorlage erstellen“.

- Nun kannst du im Editor die gewünschten Änderungen vornehmen.

- Vergiss nicht die Änderungen durch einen Klick auf den Button oben rechts zu speichern

Die getätigten Änderungen werden sofort aktiv, allerdings besucht der Crawler nicht unmittelbar nach dem Ändern deinen Shop, sondern behält seinen Rhythmus bei. In der Google Search Console gibt es einen robots.txt Tester, mit dem du deine Änderungen überprüfen kannst. Natürlich kann die robots.txt.liquid jederzeit wieder gelöscht werden.

Wie kann man Regeln in der robots.txt von Shopify definieren?

Um der Suchmaschine mitzuteilen, welche Seiten gecrawlt – oder genauer gesagt eben nicht gecrawlt – werden sollen, enthält die robots.txt Gruppen von Regeln. Jede Gruppe besteht aus drei Hauptkomponenten:

- Den User-agent der angibt, für welchen Crawler die Regel gilt, z. B. Googlebot

- Die Regel selbst, die bestimmte URLs notieren

- Eine optionale Sitemap-URL

Hinzufügen einer neuen Regel zu einer bestehenden Gruppe

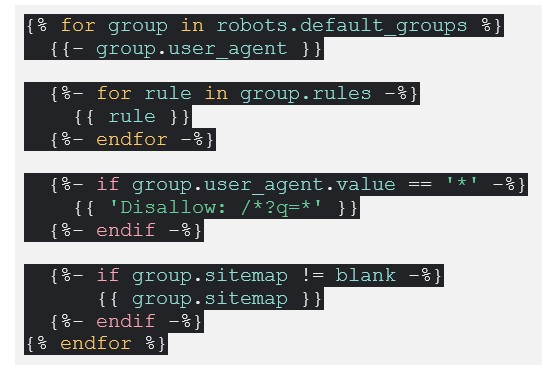

Das folgende Beispiel von Shopify zeigt, wie man Crawler über die robots.txt daran hindert, auf Seiten zuzugreifen, die ein ?q= in der URL enthalten:

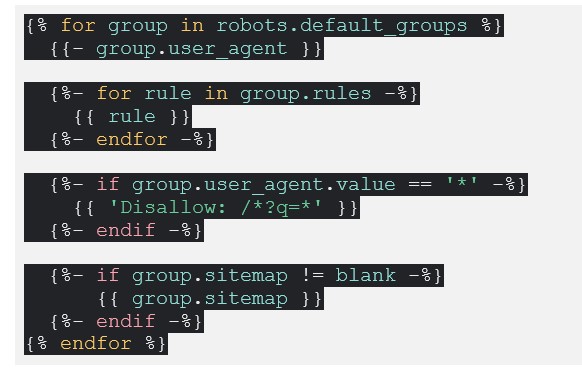

Entfernen einer Standardregel aus einer bestehenden Gruppe

Dieses Beispiel zeigt, wie du eine Regel entfernen kannst. In diesem Fall die Regel, die die Crawler daran hindert die Seiten im Verzeichnis /policies/ aufzurufen:

Benutzerdefinierte Regeln hinzufügen

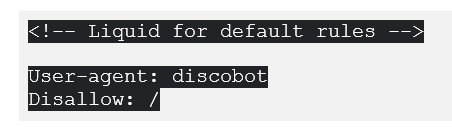

Die geschweiften Klammern mit dem Prozentzeichen weisen auf die Template-Sprache Liquid hin. Regeln, die nicht Teil einer Standardgruppe sind, kannst du außerhalb von Liquid manuell eingeben, um die Standardregeln auszugeben. Einen Crawler, der nicht im Standardregelsatz enthalten ist, blockiert du zum Beispiel wie folgt:

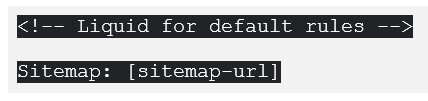

Wenn du in der robots.txt ein zusätzliches Sitemap angeben möchtest, machst du das mit folgendem Code:

Fazit: Mehr Kontrolle für alle, die sich auskennen

Das Shopify nun die individuelle Bearbeitung der robots.txt ermöglicht ist eine wichtige Funktion für Webmaster und SEOs, die dadurch mehr Kontrolle erhalten und die Aktivitäten von Suchmaschinen wie Google besser steuern können. Allerdings bedarf diese technische Maßnahme ein gewisses Know-how, auch was die Shopify-eigene Sprache Liquid betrifft.

Fehler in der robots.txt können gravierende Folgen haben und Onlineshops im wahrsten Sinne des Wortes bares Geld kosten, wenn Teile oder gar der ganze Shop plötzlich nicht mehr von Suchmaschinen indexiert wird. Wer selbst kein Profi ist, sollte sich deshalb Expertenrat bei der Bearbeitung der robots.txt holen.

Wir unterstützen dich gern!

Du möchtest wissen, ob du etwas an deiner robots.txt ändern solltest? Gern beraten wir dich und übernehmen die fachmännische Anpassung, damit du von der neuen Shopify-Funktion wirklich profitierst und sie dir nicht schadet. Nimm gern Kontakt mit uns auf!

Zurück

Hier findest du die neusten Infos aus unserem Ratgeber. Mit unseren Tipps kannst du dein Online Marketing stetig ausbauen.

Tatsächlich wurden im deutschen E-Commerce-Markt 2022 Waren im Wert von über 103…

Stellen Sie sich vor, Sie könnten einen erfolgreichen Online-Shop mit nur 30…